Die fortschreitende Digitalisierung bringt viel Neues mit sich: Neue Geschäftsmodelle, neue Technologien – und vor allem eine immer größer werdende Menge an Daten, die gesammelt, übertragen, verarbeitet und gespeichert werden müssen. Für die nächsten drei Jahre prognostizieren Experten sogar ein Wachstum dieser Datenmenge um den Faktor zehn. Ein solch enormer Anstieg bringt hohe Anforderungen an Rechenzentren mit sich – und damit auch an die dort befindlichen Storage Devices.

Pro und Contra All-Flash: Zwei wichtige Fragen

Je nach Art und Nutzung der gespeicherten Daten können diese Anforderungen variieren. In manchen Fällen sind kurze Antwortzeiten entscheidend, in anderen die Skalierbarkeit des Rechenzentrums. Auch das zur Verfügung stehende Budget hat einen wichtigen Einfluss. Es gilt, die Kosten je Terabyte zu senken. Außerdem spielt der Lebenyzyklus von Devices eine nicht unwichtige Rolle: Die Migration hunderter Tera- oder gar Petabyte ist eine große Herausforderung, der sich kein Unternehmen öfter als notwendig stellen möchte.

Um den Anforderungen an moderne Rechenzentren gerecht zu werden, ziehen viele Unternehmen All-Flash in Betracht. Doch wann ist der Einsatz der Technologie sinnvoll? Generell gilt: Es gibt viele sinnvolle Anwendungszwecke. Es gibt jedoch bestimmte Szenarien, in denen es seine Stärken besonders gut ausspielen kann. Diese möchten wir Ihnen heute zeigen – und Ihnen verraten, wann Sie auf All-Flash setzen sollten.

Um den Anforderungen an moderne Rechenzentren gerecht zu werden, ziehen viele Unternehmen All-Flash in Betracht. Doch wann ist der Einsatz der Technologie sinnvoll? Generell gilt: Es gibt viele sinnvolle Anwendungszwecke. Es gibt jedoch bestimmte Szenarien, in denen es seine Stärken besonders gut ausspielen kann. Diese möchten wir Ihnen heute zeigen – und Ihnen verraten, wann Sie auf All-Flash setzen sollten.

Wenn Sie über einen Umstieg nachdenken, sollten Sie sich zunächst zwei wichtige Fragen stellen: Müssen die Bestandteile Ihrer Architektur unabhängig voneinander wachsen können? Und: Welche Zugriffsgeschwindigkeiten muss das Rechenzentrum ermöglichen?

Anforderungen an die Skalierbarkeit

Stellen Sie sich vor, die Datenmenge, die Ihr Rechenzentrum bewältigen muss, wächst stetig an. Irgendwann ist der zur Verfügung stehende Speicherplatz erschöpft. Wenn Sie die Storage-Leistung nun erweitern – muss die vorhandene Rechenleistung linear mitwachsen? Entsteht durch eine größere Menge an Daten also auch zwingend die Notwendigkeit, diese schneller abrufbar zu machen oder eine größere Zahl an Abrufen parallel zu ermöglichen? Oder können die beiden Bestandteile relativ unabhängig voneinander wachsen?

Letzteres ist bei einer klassischen 3-Tier-Architektur mit Servern, Storage Devices und Netzwerkeinheiten der Fall. Durch die Möglichkeit des unabhängigen Wachstums erhalten Sie eine hohe Flexibilität. Solange Sie nur mehr Speicherplatz und nicht gleichzeitig eine höhere Leistung benötigen, können Sie diese Investition zunächst einsparen und bei Bedarf einfach nachholen.

Anders sieht es bei Hyperconvergered Infrastructures (HCI) aus. Hier sind Rechen- und Speicherfunktionen nicht in getrennter Hardware, sondern in einem gemeinsamen „Building Block“ mit integriertem Management-System realisiert. Die Skalierung erfolgt durch das Hinzufügen neuer Blocks. Das Wachstum von Speicher- und Rechenleistung lässt sich nicht trennen. Dafür sind die einzelnen Bestandteile von HCI „vom Werk aus“ bestmöglich aufeinander abgestimmt.

Anforderungen an die Zugriffsgeschwindigkeit

Die zweite Frage, die Sie sich stellen sollten: wie sieht es mit der Zugriffsgeschwindigkeit aus? Werden kurze Antwortzeiten zwingend benötigt oder geht es vor allem um die Bereitstellung großer Datenmengen zu möglichst geringen Kosten?

Typische Anwendungen für Architekturen mit hoher Zugriffsgeschwindigkeit sind Desktop-Virtualisierungen, Datenbanken oder Transaktions-Applikationen. Auch bei klassischen CRM, ERP und SCM sowie etlichen Arten von analytischen Anwendungen kommt es auf möglichst kurze Antwortzeiten an. Zudem ist eine hohe Verlässlichkeit wichtig, um das Timeout von Anwendungen zu vermeiden.

Typische Anwendungen für Architekturen mit hoher Zugriffsgeschwindigkeit sind Desktop-Virtualisierungen, Datenbanken oder Transaktions-Applikationen. Auch bei klassischen CRM, ERP und SCM sowie etlichen Arten von analytischen Anwendungen kommt es auf möglichst kurze Antwortzeiten an. Zudem ist eine hohe Verlässlichkeit wichtig, um das Timeout von Anwendungen zu vermeiden.

Für andere Anwendungen hingegen spielt die Zugriffszeit eine untergeordnete Rolle. So liegt bei Online-Archiven, Content Depots, historischen Daten für Analysen und Anwendungen für das Streaming der Fokus deutlich auf großen Mengen an unstrukturierten Daten, auf die aber verhältnismäßig selten zurückgegriffen wird. Das Ziel sind hier möglichst geringe Kosten je Einheit.

Wann Sie auf All-Flash setzen sollten

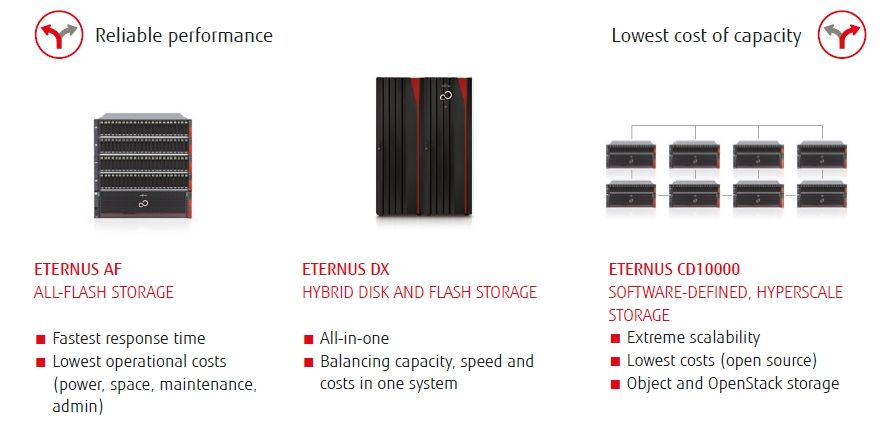

Für welches Szenario ist All-Flash nun die beste Wahl? Die einfache Antwort: Immer dann, wenn eine hohe und verlässliche Leistung benötigt wird, sind All-Flash Storage Arrays wie zum Beispiel die ETERNUS AF-Serie, die ideale Speicherlösung.

Die Storage-Medien liefern die niedrigste Latenz und sind nicht-mechanisch. Durch das Fehlen der beweglichen Mechanik reduziert sich die Ausfallquote bei SSD daher deutlich im Vergleich zu klassischen HDD. Die Skalierbarkeit wird durch das Hinzufügen weiterer Shelves erreicht (Scale Up). Die System-Software ist für den Einsatz von SSD optimiert und schnelle, interne High-Speed-Verbindungen vermeiden Flaschenhälse. Generell gilt: Je höher die benötigte Geschwindigkeit ist, desto eher sollten sie auf All-Flash Storage setzen.

Liegt der Fokus hingegen eher auf einer großen Menge an schnellwachsenden Daten, ist Scale-Out Software Defined Storage (SDS) wie die ETERNUS CD10000 die bessere Wahl. Dadurch, dass das Gesamtsystem unkompliziert um neue Knoten ergänzt werden kann, ist eine hohe Skalierbarkeit gegeben. Doch für eine angemessene Konfiguration von SDS wird eine gewisse Anzahl an Knoten benötigt. Wirklich effizient sind solche Systeme ab 200 oder 300 Terabyte an Daten, nach oben hin gibt es kaum Grenzen. In größeren Umgebungen ist auch eine Kombination von All-Flash für die Performance und Scale-Out SDS für die benötigte Kapazität denkbar – zum Beispiel in Form einer ETERNUS DX.

All-Flash ist teurer – aber nur auf den ersten Blick

Auf den ersten Blick wirkt es verlockend: SSD sind noch immer doppelt so teuer wie herkömmliche Festplatten – da ist es doch auf jeden Fall besser, auf das Bewährte zu setzen. Oder? Doch die Preisdifferenz ist nur eine Momentaufnahme. In den nächsten zwei Jahren wird der Unterschied erheblich schrumpfen. Werden einem System also im Laufe der Jahre neue Komponenten hinzugefügt, entstehen dieselben Kosten – egal ob für All-Flash oder für klassische Festplatten.

Doch im Vergleich zu herkömmlichen Festplatten haben All-Flash Arrays dann deutlich geringere operationale Kosten. Sie benötigen rund 95% weniger Energie und durch eine höhere Dichte 95% weniger Raum für dieselbe Kapazität. Technologien zur Datenreduktion wie Deduplizierung und Kompression unterstützen dies zusätzlich.

Auch wenn die Anschaffungskosten von SSD zu Beginn höher erscheinen: Am Ende benötigen Sie für dieselbe Leistung eine deutlich geringere Stückzahl als es bei den normalen Festplatten der Fall ist. Damit einher gehen geringere Lizenzkosten (durch weniger Server) und das Entfallen von notwendigen Leistungsoptimierungen oder Tuning. Die Folge: Die Kosten je Terabyte sinken deutlich.

Ihr Einstieg in All-Flash mit der ETERNUS AF150

Bei Ihrem Einstieg stehen wir Ihnen gerne zur Seite – zum Beispiel mit der ETERNUS AF150 S3. Der kostengünstige All-Flash-Storage der Einstiegsklasse ist einfach zu verwalten, skalierbar, hochverfügbar und kann effizient mit großen Datenvolumen arbeiten. Möchten Sie mehr wissen? Alle Informationen zur ETERNUS AF150 finden Sie auf unserer Webseite (Link leider nicht mehr verfügbar) – oder sprechen Sie uns einfach an.

Mehr zu den Vorteilen von ETERNUS AF All-Flash Storage erfahren Sie außerdem in unserem Video:

Sie sehen gerade einen Platzhalterinhalt von Standard. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf den Button unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.