103.278 Gigabyte je Sekunde [1] – das ist der Datenverkehr, der weltweit durch das Internet und seine Infrastruktur fließt – wohlgemerkt, je Sekunde. 4,13 Milliarden Menschen nutzen aktuell das Internet weltweit, viele von ihnen täglich [2]. Hinzu kommt außerdem die Kommunikation des Internet of Things (IoT) – also von Maschine zu Maschine, deren Anteil auch gerne einmal unterschätzt wird. So kommt eine extrem große Zahl an Nutzern und eine riesige Datenmenge zusammen, die durch neue Angebote wie YouTube, Netflix und Co., durch IoT basierte Anwendungsszenarien wie Predictive Maintenance, aber auch durch andere Einflüsse, wie zum Beispiel die Covid-19 Pandemie, vorangetrieben und in den nächsten Jahren weiterwachsen wird. Dabei ist das stetige Wachstum nur ein Faktor, dem das Netzwerk – also die Hardware und ihre Verbindungen in Form von Datenkabeln und Funkstrecken „hinter dem Internet“ – gerecht werden muss.

Abhängig von der Tageszeit schwankt die Nutzung in den einzelnen Regionen der Welt. Große, digitale Events oder lokale Katastrophen können zu kurzfristigen regionalen Spitzen in der Nutzung führen, und zu guter Letzt hat die Infrastruktur selbst Einfluss: Rechenzentren können ebenso wie kleinere Netzelemente ausfallen oder aber eine Baumaschine kann auf einer Großbaustelle auch einmal ein Kabel beschädigen und damit diese eine Route komplett lahmlegen. Wie also kann unter diesen Umständen gewährleistet werden, dass alle Nutzer*innen den bestmöglichen Up- und Download haben oder zumindest eine minimal garantierte Kapazität, so dass Arbeiten, Surfen und Streaming noch möglich ist? Um die Frage nach der Optimierung beleuchten zu können, müssen wir zunächst einen genaueren Blick auf die Infrastruktur des Internets werfen.

Aufbau des Internets und Routing

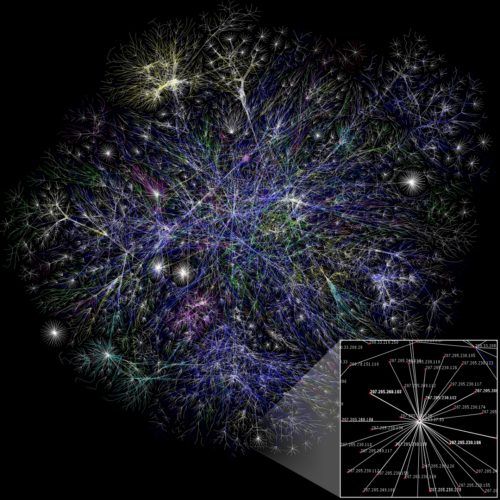

Der Aufbau des Internets ist vergleichbar mit unserem Straßensystem. Es gibt Bundesautobahnen, Bundesstraßen, Landesstraßen, Kreisstraßen und Gemeindestraßen. Diese Namen klassifizieren unter anderem die Ausbaustufe der Straße: ihre Breite, die Anzahl der Spuren, aber auch Steigung, Gefälle und Kurvenradien. Diese spezifischen Eigenschaften begründen jeweils die vorgegebenen Geschwindigkeitsbegrenzungen. Um zügig von A nach B zu kommen, wählt das Navigationssystem aus, welche Route und damit auch welche Straßen genutzt werden. In aller Regel begibt man sich von seinem Startpunkt aus immer zur nächstgrößeren Straßenkategorie bis hin zur Autobahn und wenn man sich dem Ziel nähert, vice versa.

So zu fahren geht oft bedeutend schneller, als z. B. die kürzeste Strecke zu wählen, die über Land- und Kreisstraßen führt. Doch unabhängig davon, welchen Weg man wählt: Straßen können wegen zu hohem Verkehrsaufkommen verstopfen, aber auch Baustellen und Unfälle sorgen für Störungen im Verkehrsfluss. Und genau hier stoßen wir an das Problem, dass die Route von jedem Navigationssystem nur für sich selbst optimiert wird und nicht die Ziele und Wege der umliegenden Fahrzeuge mit einrechnet. Dies führt dann z.B. dazu, dass viele Fahrer*innen in einer Stausituation dieselbe Umfahrungsentscheidung treffen und dadurch weitere Staus verursachen.

Wenn Sie jetzt das Wort Straßen durch Leitungen ersetzen, ihre Breite und die erlaubte Geschwindigkeit mit Datenraten, die sie übertragen können und aus Autos und Personen Datenpakete machen – dann haben Sie eine gute Vorstellung davon, wie die Infrastruktur für die Telekommunikation und damit das Internet aussieht.

This file is licensed under the Creative Commons Attribution 2.5 Generic license.

This file is licensed under the Creative Commons Attribution 2.5 Generic license.

Viele Faktoren beeinflussen Wege und Geschwindigkeit

Es gibt eine Vielzahl von weiteren Faktoren, die die Infrastruktur und die erreichbaren Geschwindigkeiten beeinflussen. Beispielsweise versuchen Router anhand von historischen Daten und Ereignissen den Datenfluss zu optimieren. Hierbei fließen die Erfahrungen in die Identifikation von zukünftig möglicherweise ausgelasteten Routen und Teilverbindungen ein. Dabei stößt die Vorhersage zur Identifikation von kritischen Teilstrecken jedoch durchaus an Grenzen. Der Grund dafür liegt in vielen Fällen in der kontinuierlich inflexiblen Verwendung der weniger kritischen Teil-Routen, die jeweils auf historischen Daten beruht. Gerade weil jeder Router einem Datenstrom eine weniger kritische Teilverbindung zuweisen möchte, kommt es zur Überbeanspruchung dieser Verbindungen.

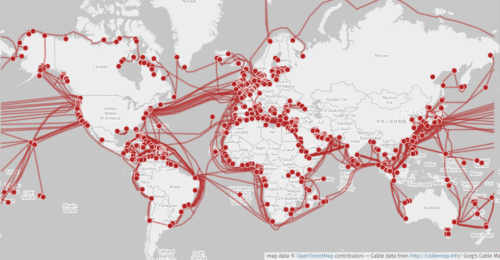

Aber auch welt- oder firmenpolitische Fragen spielen beim Datenrouting eine Rolle: welcher Firma/welchem Betreiber gehören die Kabel und wie dürfen sie genutzt werden? Dürfen Pakete auf dem Weg von Finnland nach Deutschland durch die vielleicht schnellere Landverbindung über Russland geroutet werden, oder nehmen wir einen Geschwindigkeitsverlust in Kauf, indem wir uns am stark ausgelasteten, aber dafür direkten Unterseekabel anstellen [4]?

This file is licensed under the Creative Commons Attribution-Share Alike 2.0 Generic license.

This file is licensed under the Creative Commons Attribution-Share Alike 2.0 Generic license.

Die Infrastruktur, die hinter unseren Internetanschlüssen, egal ob zu Hause oder mobil, liegt ist also sehr komplex und wird von vielen Faktoren beeinflusst. Wenn Sie sich mehr mit dem Thema beschäftigen wollen, empfehle ich Ihnen das Buch „Kabelsalat: Wie ich einem kaputten Kabel folgte und das Innere des Internets fand“ von Andrew Blum. In jedem Fall sollte jetzt deutlich geworden sein, dass es immer wieder – auch schon vor Corona – in Zeiten großer Auslastung zu Datenstaus kommen kann, die das Nutzungserlebnis stark beeinträchtigen. Und hier kommen wir zurück zur Optimierung. Erinnern Sie sich kurz an die „egoistischen“ Autofahrer*innen und ihre Navigationssysteme: sie optimieren nur die Route für sich selbst und berücksichtigen nicht, welche Ziele die Fahrzeuge um sie herum haben. Ein Telekommunikationsprovider hingegen kommt mit einer solchen, „egoistischen“ Lösung nicht weit. Er muss sich die Ziele aller Datenpakete in seinem Netzwerk anschauen und jedem eine Route zuweisen, so dass alle Pakete gemeinsam ihr Ziel in der bestmöglichen Zeit erreichen. Das ist eine komplexe kombinatorische Aufgabe, die mit der heute verfügbaren Rechenleistung nur sehr schwer zu lösen ist.

Kombinatorische Optimierung ist Trumpf oder zu langsam

„Kombinatorische Probleme können exponentiell wachsen, wenn es darum geht, jede mögliche Zusammensetzung zu betrachten“, erläutert Dr. Sebastian Engel, Technical Consultant für den Digital Annealer bei Fujitsu. „Nehmen wir zum Beispiel an, Sie haben eine große Familie und möchten an Weihnachten Ihre Geschenke überbringen. Auf Grund von Corona wird das dieses Jahr nicht bei einer großen Familienfeier möglich sein, sondern Sie müssen zu jedem Haushalt einzeln fahren und dort natürlich kontaktfrei Ihr Päckchen hinterlassen. Die Reihenfolge spielt dabei keine Rolle, aber aus Nachhaltigkeitsgründen soll der Gesamtweg natürlich so kurz wie möglich sein.

Public Domain Image from Wikipedia/CIA World Factbook

Suchen Sie sich zehn beliebige Adressen auf einer Straßenkarte und schon erkennen Sie, dass die Anzahl der möglichen Reihenfolgen extrem groß ist. Genauer gesagt haben Sie bei zehn Haushalten rund 3,63 Millionen Möglichkeiten (= 10 x 9 x 8 x … = 10 Fakultät), um Ihre Geschenke zu überreichen. Und Sie müssen sich alle Möglichkeiten ansehen, um herauszufinden, welche nun die kürzeste Route ist“, so Dr. Engel weiter. Also auch, wenn jede einzelne Möglichkeit an sich schnell berechnet werden kann, die Vielzahl dieser bringt konventionelle Rechner und auch HPCs regelmäßig an ihre Grenzen. [5]

Die Lösung dafür könnte und wird irgendwann in der Zukunft auch „Quantencomputer“ lauten. „Quantencomputer haben, in einem ganz praktischen Sinne gesprochen, die Eigenschaft bestimmte Rechenoperationen exponentiell schneller lösen zu können als kommerzielle Rechner“, erläutert Dr. Marc Geitz von den Telekom Innovation Laboratories (T-Labs). „Das macht dies sehr attraktiv, denn viele dieser Problemstellungen sind relevant für die Forschung, aber auch Industrie. Und klassische Rechner stoßen langsam an physikalische Grenzen, was die Miniaturisierung ihrer Architektur angeht, denn es treten bereits jetzt Quanteneffekte dort auf, wo man sie nicht haben will und auch die Ableitung der entstehenden Hitze wird immer schwieriger.“

Digital Annealing vs. Quanten Annealing

„Quanten Annealer arbeiten mit Quantenzuständen“, so fährt der promovierte Physiker Geitz fort, „das sind zum Beispiel kleine quantenmechanische Magneten oder Atomzustände. Für ihren Betrieb wird eine komplexe Infrastruktur benötigt: sie müssen von magnetischen Feldern isoliert und nahe dem absoluten Nullpunkt betrieben werden. Während der Berechnung orientieren sich die quantenmechanischen Magneten so aus, dass die Gesamtenergie der QPU (Quantum Processing Unit) minimiert wird. Die resultierende Ausrichtung ergibt dann das Ergebnis der Berechnung. Während der Berechnung kommt es bei aktueller Hardware zu Störungen, so dass die Kohärenz der Quantenzustände auf der QPU nicht notwendigerweise erhalten bleibt, was letztendlich die Leistungsfähigkeit aktueller Hardware limitiert. Die Hardware verbessert sich von Jahr zu Jahr, so dass wir hoffen, in den kommenden Jahren eine wirkliche Quanten Advantage zu sehen.“ Damit sind Quanten Gate Computer und Quanten Annealer noch nicht da, wo sie für den produktiven Einsatz in der Industrie sein müssten.

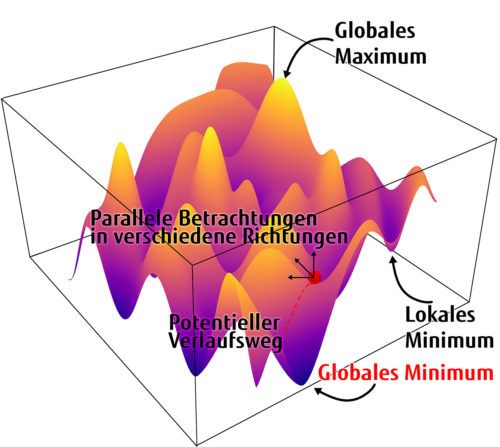

„Der Digital Annealer stellt dagegen eine Brückentechnologie zwischen klassischen Computer-Systemen und Quanten Annealern dar. Basierend auf Silizium-Prozessortechnologie emuliert der Mikrochip Quanten Annealing, sprich seine spezielle Architektur nutzt die Funktionsprinzipien von Quanten Annealern, um kombinatorische Probleme sehr schnell und effizient zu lösen. Und das ohne den technischen Aufwand, den der Betrieb eines Quantencomputers erfordern würde. Dabei liefert der Digital Annealer die volle Konnektivität aller Bits, also jedes Bit kann mit jedem anderen kommunizieren“, fährt Sebastian Engel fort. „Und auch das Prinzip der Superposition wird nachgezeichnet: ich gehe iterativ durch den Annealing-Algorithmus und bei jedem Schritt schaue ich parallel in eine Vielzahl von möglichen Richtungen, sprich verändere jede Variable um eine Einheit, von welcher ich die Beste gefundene Veränderung annehmen kann.

Auch das sogenannte Quanten-Tunneling lieferte Inspirationen für das Chipdesign: gegen Ende eines Quanten Annealings befindet sich der Algorithmus in einem Tal, einem Energieminimum. Aber handelt es sich um ein globales Minimum oder ein Lokales? Und liegt in direkter Nachbarschaft vielleicht ein noch besseres Energieminimum? Der Digital Annealer geht das Problem mit Wartezyklen an, indem er sich das Beste, bereits gefundene Minimum merkt und den Algorithmus noch einmal ‚aus dem Tal schubst‘ und ihm so erlaubt, die nähere Umgebung weiter zu untersuchen.“ Zusammengefasst kann man daher sagen: Im Vergleich zu heute verfügbaren Quantencomputern hat der Digital Annealer eine deutlich höhere Anzahl an nutzbaren Bits und eine höhere Präzision. Die technische Praxistauglichkeit der Architektur ist daher der große Vorteil des Digital Annealers und ermöglichen die Betrachtung von industrierelevanten Problemen.

Infrastruktur optimieren – Wie beginnt man so etwas?

„In den T-Labs arbeiten wir an wissenschaftlichen Fragestellungen in Bezug auf die Telekommunikation der Zukunft. Dabei sind wir auch auf der Suche nach neuen Technologien und Anwendungen, die einem Telekommunikationsdistributor, also in diesem Fall der Deutschen Telekom, in den nächsten drei bis fünf Jahren einen nicht unerheblichen Vorteil bringen können“, erklärt Marc Geitz die Motivation, den Digital Annealer auszuprobieren. „Jedes Projekt, beziehungsweise jeder Proof of Concept, beginnt damit, dass zunächst einmal die Problemstellung gemeinsam mit dem Kunden erarbeitet wird. Das geschieht oft mit Hilfe unseres Human-Centric Co-Creation Ansatzes. Dabei ist es wichtig, dass wir verschiedene Herausforderungen und Prozesse beleuchten, denn nicht jede Fragestellung ist für Quanten Annealer oder Quantum-inspirierte Technologien wie den Digital Annealer wirklich geeignet. Es muss immer identifiziert werden, ob eine bestimmte Problemstellung mit einem klassischen algorithmischen Ansatz, durch einen Quanten Solver oder Digital Annealer gelöst werden kann“, beschreibt Dr. Engel die ersten Schritte.

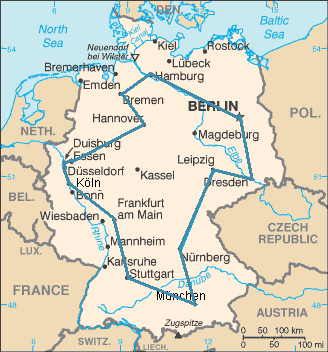

„Unser Problem bzw. unsere Fragestellung ist nun: das Netz ist ein sehr komplexes Gebilde. Große Städte sind mit Glasfasersträngen verbunden und das heißt, wir haben hier – ähnlich wie bei Autobahnen oder Bundesstraßen auch – verschiedene Möglichkeiten, um zum Beispiel von Frankfurt am Main nach Berlin zu gelangen. Wie genau müssen wir nun die Datenströme in ihrer Gesamtheit routen, damit das Netz idealerweise eine mittlere Auslastung auf allen Strecken erfährt. Denn in diesem Zustand fühlt es sich am wohlsten, wenn man es poetisch ausdrücken möchte“, erläutert der Experte von den T-Labs das identifizierte Problem. „Dazu arbeiten wir in einem Dreiergespann zusammen: Fujitsu, wir als T-Labs und die Fachabteilung der Deutschen Telekom, in diesem Fall natürlich die Kolleginnen und Kollegen vom Netzbetrieb.“ Durch den regelmäßigen, fachübergreifenden Austausch gewährleistet der Co-creation Ansatz, dass alle Stakeholder*innen eines Projektes gesehen werden und ihre Perspektive mit einbringen können.

Kombinatorische Optimierung: Ohne Mathematik funktioniert es nicht

Im nächsten Schritt muss das Problem nun in Mathematik gegossen werden. Hier kommen die Expert*innen von Fujitsu zum Einsatz, die auf dem Gebiet der kombinatorischen Optimierung für die Industrie bereits in verschiedenen Projekten Erfahrungen sammeln konnten. So erklärt Dr. Engel die nächsten Schritte: „Bei kombinatorischen Problemen geht es in der Regel um zwei Dinge: zunächst müssen Energie oder Kosten für einen bestimmten Ablauf minimiert werden. Das erfolgt oft unter gewissen Bedingungen, Wenn-Dann-Beziehungen oder Fallunterscheidungen. Das übersetzen wir dann in die Sprache der Mathematik, idealerweise direkt in sogenannte binäre quadratische Polynome. Manchmal sind dafür Zwischenschritte erforderlich, manchmal muss das Modell vereinfacht werden – all dies sind jedoch Entscheidungen, die immer im Wechselspiel mit dem Kunden getroffen und diskutiert werden, da diese Zwischenschritte erheblich von den realen Bedingungen abhängen.“

„In diesem Zusammenspiel entsteht natürlich auch ein großer Wettbewerbsvorteil für uns. Denn neben der Erprobung neuer Technologien und der Einschätzung ihres Potentials für einen Telekommunikationsdistributor, lernen wir unheimlich viel dabei. In diesem Fall, die Erstellung der korrekten mathematischen Modelle, die auch Qubos (Quadaratic Unconstrained Binary Optimization) genannt werden“, hebt Dr. Geitz hervor. „Dadurch, dass wir jetzt bereits beginnen diese Modelle auf dem Digital Annealer zu entwickeln, haben wir bei einem zukünftigen Übergang zum Quanten Annealer keine Wrap-Up oder Trainingsphase, und können direkt durchstarten.“

Ist das Modell fertig, kommt der Digital Annealer zum Einsatz und löst die entsprechenden Algorithmen.

Was konnten wir erreichen?

„Im letzten Schritt eines jeden Projektes muss der Digital Annealer gegen die aktuell verwendeten Lösungen beim Kunden bestehen und zeigen, ob und wenn ja in welchem Rahmen, Verbesserungen erzielt wurden. Dies bezieht sich zumeist auf die benötigte Rechenzeit und die Qualität der Ergebnisse„, betont Dr. Engel, „denn am Ende steht der Nutzen für das Business des Kunden im Vordergrund.“ Dr. Geitz bestätigt: „Bei der Optimierung des Routings von Datenpaketen haben wir auch verschiedene Methoden und damit Modelle des Routings miteinander verglichen. So wurden beispielsweise Modelle für das Multicommodity Flow Routing, das Two Segment Routing und Source Routing erstellt.“ Die Ergebnisse der Zusammenarbeit zwischen den T-Labs und Fujitsu sehen bereits sehr vielversprechend aus und unsere Evaluierungsergebnisse zeigen, dass das Routing nahezu optimale Ergebnisse liefert und dennoch mit angemessenem Aufwand einsetzbar ist.

Zukünftige Projekte

Für die Zukunft sind weitere Zusammenarbeiten geplant, zum Beispiel im Mobilfunk: das Frequency Assignment, das als eine komplexe Variante des Color-Map Problems verstanden werden kann, um zum Beispiel Interferenzen zu minimieren und damit die Gesprächsqualität zu erhöhen. Ebenso soll die Nutzung des Digital Annealers im Bereich des Maschinellen Lernens untersucht werden. Beide Firmen sind außerdem Partner im vom BMWi geförderten Projekt PlanQK, bei dem gemeinsam mit anderen Unternehmen und Forschungseinrichtungen an einer Plattform und einem Ökosystem für Quantenunterstütze Künstliche Intelligenz gearbeitet wird. „Wir befinden uns auf der Suche nach den Applikationsklassen im Telekommunikationsumfeld, die besonders von möglichen Gewinnen durch Quantenrechnern profitieren können“, schließt Dr. Marc Geitz das Gespräch.

Weitere Informationen zum Digital Annealer finden Sie auf unserer Webseite.